零基础入门大数据开发技术 从构建知识体系到实战的完整路径

引言

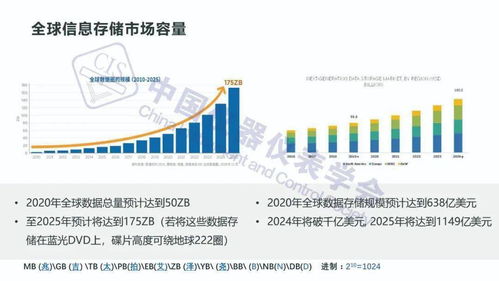

大数据技术已成为驱动现代商业与科技创新的核心引擎之一,从精准营销、智能推荐到风险控制、智慧城市,其应用无处不在。对于零基础的学习者而言,大数据开发领域看似高深莫测,但只要遵循科学的学习路径,掌握核心技术与思维方式,完全可以从入门走向精通。本文将为你系统梳理一条清晰、可行的学习路线图。

第一步:筑牢根基——打好计算机与数据基础

万丈高楼平地起,学习大数据开发,必须先建立坚实的知识底座。

- 编程语言:选择一门主流的编程语言深入学习。Java 因其在企业级应用中的稳定性和生态完整性,是大数据生态(如Hadoop、Spark)的首选语言。掌握 Python 也至关重要,它在数据分析、机器学习脚本编写和数据预处理方面极为高效。

- 数据结构与算法:理解基础的数据结构(数组、链表、栈、队列、树、图)和常用算法(排序、查找),这对后续理解分布式计算框架的内部原理和优化数据处理性能有极大帮助。

- Linux操作系统:大数据生态主要部署在Linux服务器上。务必熟悉常用的Linux命令、Shell脚本编写以及系统管理的基础知识。

- 数据库知识:从关系型数据库(如MySQL)入手,掌握SQL语言。进而了解NoSQL数据库(如HBase、Redis)的基本概念,理解它们与关系型数据库的差异及适用场景。

第二步:理解核心——掌握大数据技术栈

在打好基础后,需要系统学习大数据领域的核心技术组件。建议按照数据处理流程的顺序进行学习:

- 数据存储:

- Hadoop HDFS:理解分布式文件系统的设计思想、架构和基本原理。

- HBase:学习其作为分布式、面向列存储的数据库的特性与使用。

- 资源管理与调度:

- Hadoop YARN:了解其作为集群资源管理框架的角色。

- 批处理计算:

- Hadoop MapReduce:虽然其编程模型相对原始,但理解其“分而治之”的思想对学习分布式计算至关重要。

- Apache Spark:这是当前的核心技能。重点学习其基于内存计算的RDD、DataFrame/Dataset API,理解其相比MapReduce的巨大优势。掌握使用Spark Core和Spark SQL进行大规模数据批处理。

- 实时流处理:

- Apache Kafka:作为分布式消息队列,是实时数据管道的基石。掌握其生产者-消费者模型、主题、分区等核心概念。

- Apache Flink 或 Spark Streaming:选择其中一个深入学习。Flink因其真正的流式处理和优秀的状态管理而日益流行。掌握流处理的核心概念,如窗口、时间语义、状态管理等。

- 数据仓库与查询:

- Hive:学习如何使用类SQL(HQL)在Hadoop上进行数据查询与分析,理解其作为数据仓库工具的角色。

第三步:融会贯通——构建项目驱动的实战能力

理论学习必须与动手实践紧密结合。

- 搭建实验环境:可以在个人电脑上使用虚拟机,或利用云服务商(如阿里云、AWS)提供的免费试用资源,搭建一个多节点的Hadoop/Spark伪分布式或完全分布式集群。

- 进行数据操作:在集群上实际操作HDFS命令,使用Hive创建表并执行查询,编写简单的MapReduce或Spark程序处理示例数据。

- 完成端到端项目:这是能力跃升的关键。尝试完成一个完整的、小型的项目,例如:

- 项目示例:搭建一个简单的网站用户行为分析系统。

- 数据采集:使用Flume或编写脚本模拟日志生成,并收集到HDFS。

- 数据存储:将原始数据存入HDFS,处理后的结构化数据存入Hive表。

- 数据处理:使用Spark进行数据清洗、转换和聚合分析(如分析PV/UV、用户活跃时段等)。

- 数据展示:将分析结果导出到MySQL,再通过一个简单的Web界面(如使用Python Flask框架)进行图表展示。

- 学习辅助工具:在项目中融入版本控制(Git)、项目构建工具(Maven/Sbt)和任务调度工具(如Azkaban、Airflow)的使用。

第四步:深化与拓展——关注前沿与生态

- 云原生大数据:了解各大云平台(AWS EMR, Azure HDInsight, 阿里云MaxCompute/DataWorks)提供的托管大数据服务。

- 数据湖与数据湖仓一体:学习Delta Lake、Apache Iceberg等表格式,理解现代数据架构。

- 数据治理与质量:了解元数据管理、数据血缘、数据质量监控等概念。

- 持续学习:大数据技术迭代迅速,需持续关注Apache官网、技术博客、社区(如Stack Overflow、GitHub)和优秀的技术书籍。

学习建议与心态调整

- 保持耐心与恒心:零基础入门到胜任初级开发岗位,通常需要6-12个月持续、专注的学习。遇到难题是常态,善于利用搜索引擎和技术社区解决问题。

- 先广度后深度:初期对各组件有整体认识,知道它们“是什么”和“解决什么问题”,再针对求职或兴趣方向进行深度钻研。

- 重视官方文档:英文官方文档永远是最准确、最及时的一手资料,培养阅读能力至关重要。

- 构建知识网络:将学到的技术点串联起来,理解数据从产生、采集、存储、处理到应用的全链路,形成系统观。

###

学习大数据开发是一场充满挑战但也收获丰硕的旅程。从零开始,意味着你正在构建一个从底层原理到上层应用的完整知识体系。这条路径没有捷径,但方向清晰:夯实基础 -> 掌握核心 -> 项目实战 -> 持续深化。今天迈出的第一步,正是通往数据智能未来的坚实基石。立即开始行动,在数据的海洋中扬帆起航吧!

如若转载,请注明出处:http://www.echobai.com/product/33.html

更新时间:2026-02-24 19:08:17